Table of Contents

Imaginez que vous puissiez déguster un plat étoilé chez vous, sans avoir à réserver dans un restaurant. C’est exactement ce qu’Ollama offre avec l’IA : la liberté d’exécuter des modèles de langage puissants directement sur votre ordinateur, sans dépendre d’internet ou des serveurs d’une entreprise. Local signifie que tout se passe dans votre machine, comme un chef privé qui travaille dans votre cuisine. Les avantages ? Confidentialité, personnalisation, et une opportunité unique d’apprendre comment fonctionnent ces "cerveaux virtuels".

Comprendre les Bases 🧠

Avant de plonger dans l’installation, clarifions quelques concepts clés avec des métaphores accessibles.

Qu’est-ce qu’un Modèle d’IA ?

Un modèle d’IA est comme un livre géant rempli de connaissances et de motifs linguistiques. Imaginez un dictionnaire qui aurait digéré des milliards de phrases, d’articles scientifiques, de romans, et de conversations. Lorsque vous posez une question à l’IA, elle feuillette ce livre invisible pour trouver des réponses plausibles. Llama 3.1, Mistral, ou TinyLlama sont des exemples de ces "livres", chacun ayant son style (technique, créatif, concis).

Pourquoi Ollama ?

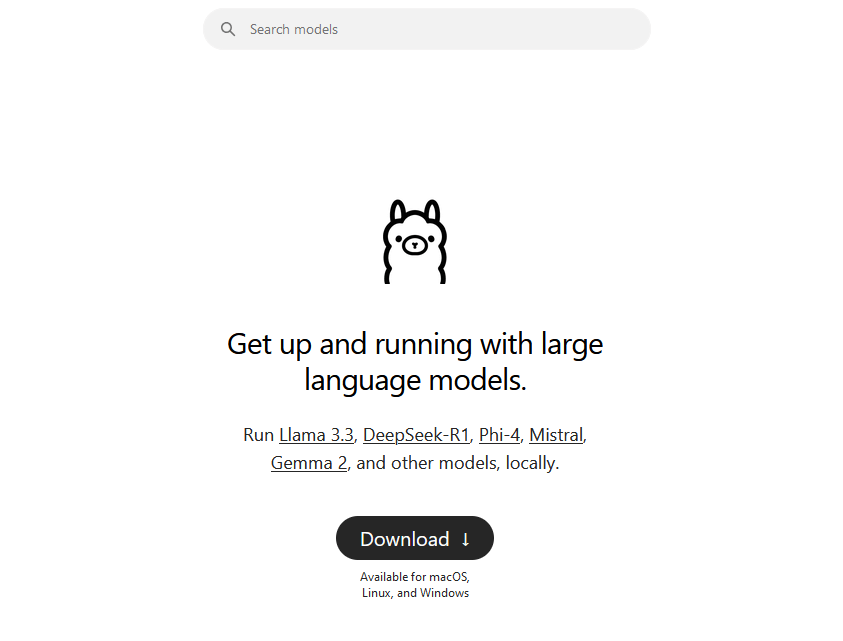

Parce qu'il agit comme un bibliothécaire numérique. Son rôle est d’installer, organiser, et exécuter ces modèles sur votre ordinateur. C’est une interface simple qui transforme des commandes techniques en actions compréhensibles, comme un traducteur entre vous et la machine.

Préparer Votre Environnement 🛠️

Pour accueillir votre IA, votre ordinateur doit être prêt. Pas de panique : voici ce dont vous avez besoin, expliqué en termes culinaires.

Un ordinateur récent : Les modèles d’IA sont gourmands en ressources. Sur Windows ou macOS, assurez-vous d’avoir une version à jour (2020 ou plus récent). Pour Linux, une distribution comme Ubuntu 22.04 fonctionnera bien.

Espace de stockage : Prévoyez 10 à 20 Go d’espace libre, comme une armoire assez grande pour stocker des ingrédients spéciaux. Les modèles sont volumineux car ils contiennent des milliards de paramètres (pensez à des recettes ultra-détaillées).

Connaissances de base en terminal : Le terminal est votre plan de travail numérique. Si vous savez exécuter des commandes comme

cd(changer de dossier) ouls(lister des fichiers), c’est suffisant. Sinon, considérez-le comme l’apprentissage du maniement d’un couteau de chef : intimidant au début, mais essentiel.

Installation d’Ollama 🖥️

Passons à la pratique. Selon votre système d’exploitation, suivez ces instructions détaillées:

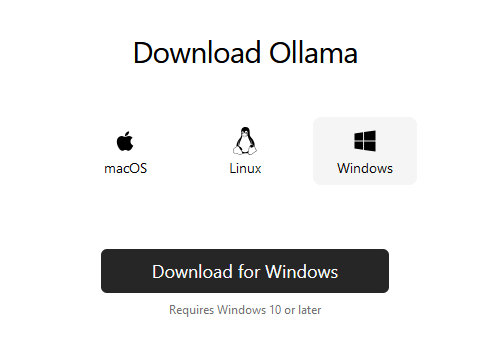

Sur Windows

Téléchargez l’exécutable : Sur ollama.com, choisissez Download for Windows. Ouvrez le fichier

.exeet suivez les instructions – c’est aussi simple qu’installer un jeu vidéo.Utilisez Winget (optionnel) : Si vous aimez les raccourcis, ouvrez PowerShell ou Terminal Windows et tapez :

winget install ollama.ollama Winget est comparable à un service de livraison de logiciels : il récupère Ollama depuis un dépôt officiel et l’installe sans effort.

Sur Linux

Les utilisateurs de Linux adorent contrôler chaque étape. Collez cette commande dans votre terminal :

curl -fsSL https://ollama.com/install.sh | sh

Cette ligne télécharge un script d’installation et l’exécute immédiatement.

Sur macOS

Téléchargez l’application : Rendez-vous sur ollama.com, cliquez sur Download for macOS, et glissez-déposez le fichier

.dmgdans votre dossier Applications. C’est comme ajouter un nouvel ustensile high-tech à votre cuisine.Lancez Ollama : Ouvrez Finder, allez dans Applications, et double-cliquez sur l’icône Ollama. Un terminal s’ouvrira automatiquement en arrière-plan – c’est le moteur qui fait tourner votre IA.

Vérifiez l’installation : Ouvrez le Terminal et tapez

ollama --version. Si vous voyez un numéro (ex.0.1.15), félicitations ! Ollama est installé.

Alternative pour les Geek :

Si vous préférez utiliser Homebrew (un gestionnaire de paquets pour macOS), collez cette ligne dans le terminal :

brew install ollama Homebrew agit comme un sommelier logiciel : il trouve, télécharge, et installe les programmes à votre place.

Exécuter Votre Première IA 🚀

Maintenant que tout est installé, il est temps de lancer votre modèle. Suivez ce guide pas à pas.

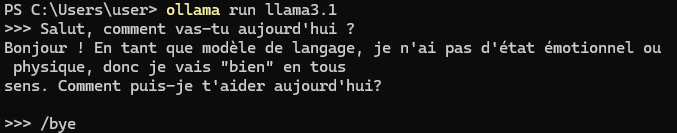

Ouvrez le terminal : Sur macOS ou Linux, cherchez Terminal dans vos applications. Sur Windows, utilisez PowerShell ou Terminal Windows.

Téléchargez un modèle : Tapez la commande suivante pour démarrer Llama 2, un modèle polyvalent créé par Meta (Facebook) :

ollama run llama3.2

La première fois, Ollama téléchargera les fichiers nécessaires (environ 4 Go). Imaginez cela comme le téléchargement d’un jeu vidéo : plus votre connexion est rapide, plus ce sera court.- Interagissez avec l’IA : Une fois le téléchargement terminé, vous verrez un prompt

>>>. Posez une question ! Par exemple :>>> Explique-moi la photosynthèse comme si j’avais 5 ans.

L’IA répondra avec une explication simplifiée, par exemple : "La photosynthèse, c’est quand les plantes utilisent la lumière du soleil pour fabriquer leur nourriture, comme si elles cuisinaient avec de la lumière !"

Personnalisation Avancée des Paramètres 🎛️

Ollama offre plusieurs paramètres ajustables pour affiner le comportement des modèles de langage selon vos besoins spécifiques. Voici les principaux :

Température (

temperature) : Contrôle la créativité des réponses générées. Une valeur basse (proche de 0) rend les réponses plus déterministes et factuelles, tandis qu'une valeur élevée (proche de 1) les rend plus variées et créatives.- Utilisation : Pour des réponses précises, utilisez une température basse. Pour encourager la créativité, augmentez la température.

Top-p (

top_p) : Aussi connu sous le nom de "nucléus sampling", ce paramètre restreint le choix des mots aux options cumulant une probabilité totale detop_p. Par exemple,top_p=0.9limite la sélection aux mots représentant 90% de la probabilité cumulée.- Utilisation : Ajustez

top_ppour équilibrer diversité et cohérence dans les réponses.

- Utilisation : Ajustez

Top-k (

top_k) : Limite la sélection auxkmots les plus probables. Par exemple,top_k=50signifie que le modèle choisira parmi les 50 mots les plus probables lors de la génération de chaque mot.- Utilisation : Un

top_kbas rend les réponses plus conservatrices, tandis qu'untop_kélevé augmente la diversité.

- Utilisation : Un

Pénalité de répétition (

repeat_penalty) : Applique une pénalité aux mots déjà générés pour éviter les répétitions excessives.- Utilisation : Ajustez ce paramètre pour améliorer la fluidité et la cohérence des réponses.

Fenêtre de contexte (

num_ctx) : Définit le nombre de tokens que le modèle peut prendre en compte lors de la génération d'une réponse. Une fenêtre plus grande permet au modèle de considérer plus de contexte, mais nécessite plus de ressources.- Utilisation : Ajustez en fonction de la longueur attendue des interactions.

Utilisation de l'API d'Ollama pour l'Intégration 🛠️

Ollama propose une API RESTful qui facilite l'intégration des modèles de langage dans vos applications. Voici comment procéder :

Lancer le Serveur :

- Assurez-vous qu'Ollama est installé et exécutez le serveur en arrière-plan.

Envoyer une Requête à l'API :

- Utilisez des outils comme

curlou des bibliothèques HTTP dans votre langage de programmation préféré pour envoyer des requêtes POST à l'API. - Exemple avec

curl:

- Utilisez des outils comme

Cette requête envoie un message au modèle llama3.2 pour obtenir une réponse à la question posée.

Paramètres de la Requête :

model: Spécifie le modèle à utiliser (par exemple,llama3.2).messages: Une liste de messages représentant l'historique de la conversation. Chaque message a un rôle (userouassistant) et un contenu.stream(optionnel) : Si défini surfalse, l'API renverra la réponse complète en une seule fois.temperature,top_p,top_k, etc. : Vous pouvez inclure ces paramètres pour personnaliser le comportement du modèle lors de la génération de la réponse.

Traitement de la Réponse :

- L'API renvoie une réponse au format JSON contenant le message généré par le modèle.

- Exemple de réponse:

Cas Pratiques et Inspirations 💡

Maintenant que tout fonctionne, explorons des idées pour exploiter votre IA.

Rédaction Assistée

Demandez à l’IA de générer des idées d’articles, de corriger vos textes, ou même d’écrire un poème. Exemple :

>>> Rédige un haïku sur le changement climatique.

Aide au Codage

Les modèles comme WizardCoder peuvent expliquer des concepts Python ou déboguer du code. Essayez :

ollama run wizardcoder

Puis posez :

>>> Comment créer une calculatrice en Python ?

Apprentissage des Langues

Utilisez l’IA pour traduire des phrases ou pratiquer une conversation en espagnol, allemand, etc.

L’IA Locale, une Révolution Personnelle 🌍

Vous avez désormais le pouvoir d’exécuter des intelligences artificielles chez vous, comme un artisan qui maîtrise ses outils. Que ce soit pour apprendre, créer, ou simplement expérimenter, Ollama ouvre un monde de possibilités. Et rappelez-vous : chaque grand voyage commence par un premier pas – le vôtre vient d’être franchi.

Appel à l’Action : Votre Tour de Briller ✨

👉 Quel sujet souhaiteriez-vous explorer ensuite ? Vos idées guideront nos prochains tutoriels. Voici quelques suggestions :

- "Déployer CommandoVM et FlareVM pour un laboratoire de cybersécurité ultime."

- "Maîtriser un outil incontournable de l'infosec, comme Burp Suite"

- "Comment intégrer l'IA dans un projet pour automatiser des tâches."

Laissez un commentaire avec votre choix – ensemble, transformons votre curiosité en expertise. 🚀