Imaginez que vous avez un assistant personnel ultra-intelligent, capable de répondre à vos questions, rédiger du texte, coder ou encore analyser des données... mais au lieu de dépendre d'Internet et d'envoyer vos requêtes à des serveurs distants, cet assistant fonctionne directement sur votre propre ordinateur. 🖥️✨ C'est exactement ce que permet LM Studio, une plateforme qui vous donne accès à des modèles d'intelligence artificielle (LLMs) en local, sans dépendre du cloud. Dans ce tutoriel, nous allons voir comment installer LMStudio, étape par étape, et comprendre les concepts clés associés.

Qu'est-ce que LM Studio ? 🤔

C'est une application de bureau qui permet d'exécuter des modèles de langage de grande taille (LLMs) localement sur votre ordinateur. Concrètement, cela signifie que vous pouvez discuter avec une intelligence artificielle avancée sans connexion Internet et sans envoyer vos données à un serveur externe. 🔒

✨ Fonctionnalités principales

- Une interface de chat intuitive et familière 🗨️

- Un moteur de recherche et de téléchargement de modèles via Hugging Face 🤗

- Un serveur local compatible avec les API OpenAI 🌐

- Un système de gestion de modèles et de configurations avancées ⚙️

🏗️ Prérequis et configuration minimale

Avant d’installer l'application, vérifiez que votre machine répond aux exigences suivantes :

🖥️ macOS

- Processeur : Apple Silicon (M1/M2/M3/M4)

- Système : macOS 13.4 ou plus récent (14.0+ pour les modèles MLX)

- RAM : 16 Go minimum recommandé (8 Go possible mais limité)

🖥️ Windows

- Processeur : x64 ou ARM64 (Snapdragon X Elite)

- Système : Windows 10/11

- RAM : 16 Go minimum recommandé

- CPU : Support de l'instruction AVX2 requis

🐧 Linux

- Système : Ubuntu 20.04 ou plus récent

- Architecture : x64 uniquement (aarch64 non supporté pour l’instant)

- CPU : Support de l'instruction AVX2 requis

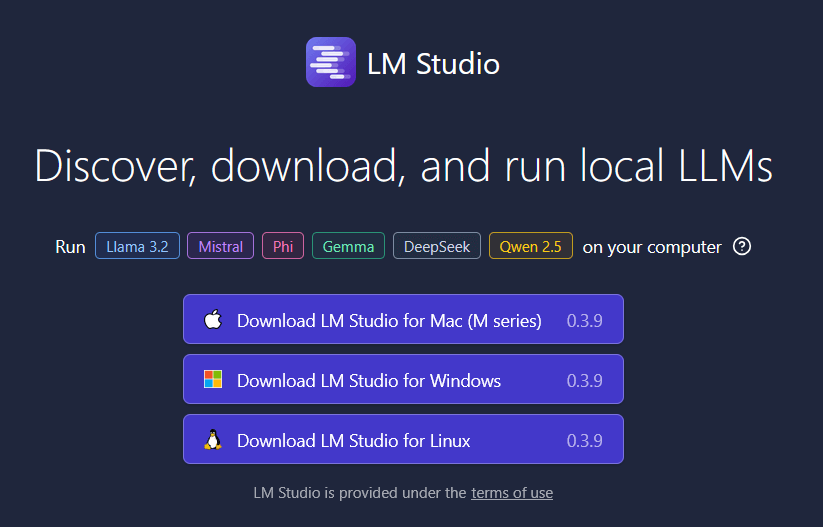

📥 Installation de LM Studio

1️⃣ Télécharger LM Studio

📌 Rendez-vous sur la page de téléchargement officielle et téléchargez l’installeur correspondant à votre système.

2️⃣ Installer LM Studio

Sous Windows 🏁

- Double-cliquez sur le fichier

.exetéléchargé. - Suivez les instructions de l'assistant d'installation.

- Une fois terminé, lancez l'application depuis le menu Démarrer.

Sous macOS 🍏

- Ouvrez le fichier

.dmg. - Faites glisser l’icône du logiciel dans le dossier Applications.

- Lancez l'application depuis le Finder ou Spotlight.

Sous Linux 🐧

- Rendez-vous dans votre dossier de téléchargement :

cd ~/Téléchargements - Ajoutez les permissions d’exécution :

chmod +x LMStudio.AppImage - Exécutez la commande suivante:

./LMStudio.AppImage

🚀 Démarrer avec LM Studio

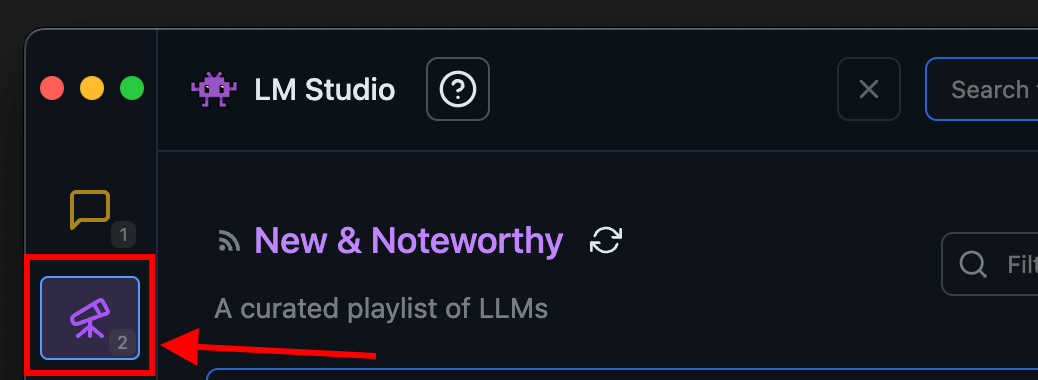

📌 Télécharger un modèle IA

- Ouvrez l'application et allez dans l’onglet Discover.

- Recherchez un modèle (ex: "Llama", "Phi-3", "Gemma").

- Sélectionnez une version en fonction de votre puissance matérielle.

- Cliquez sur "Download" pour récupérer le modèle.

📌 Astuce : Utilisez ⌘ + 2 (Mac) ou Ctrl + 2 (Windows/Linux) pour accéder rapidement à l’onglet Discover.

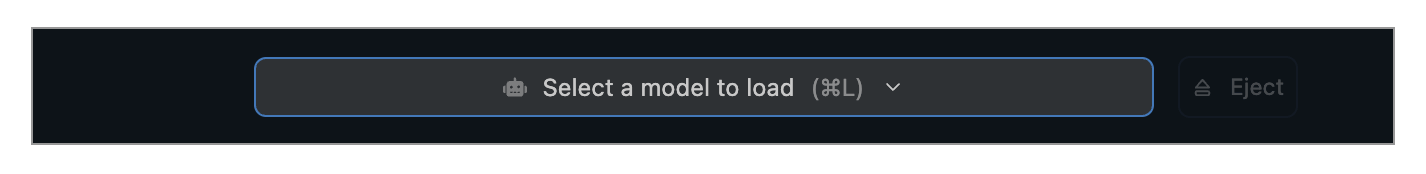

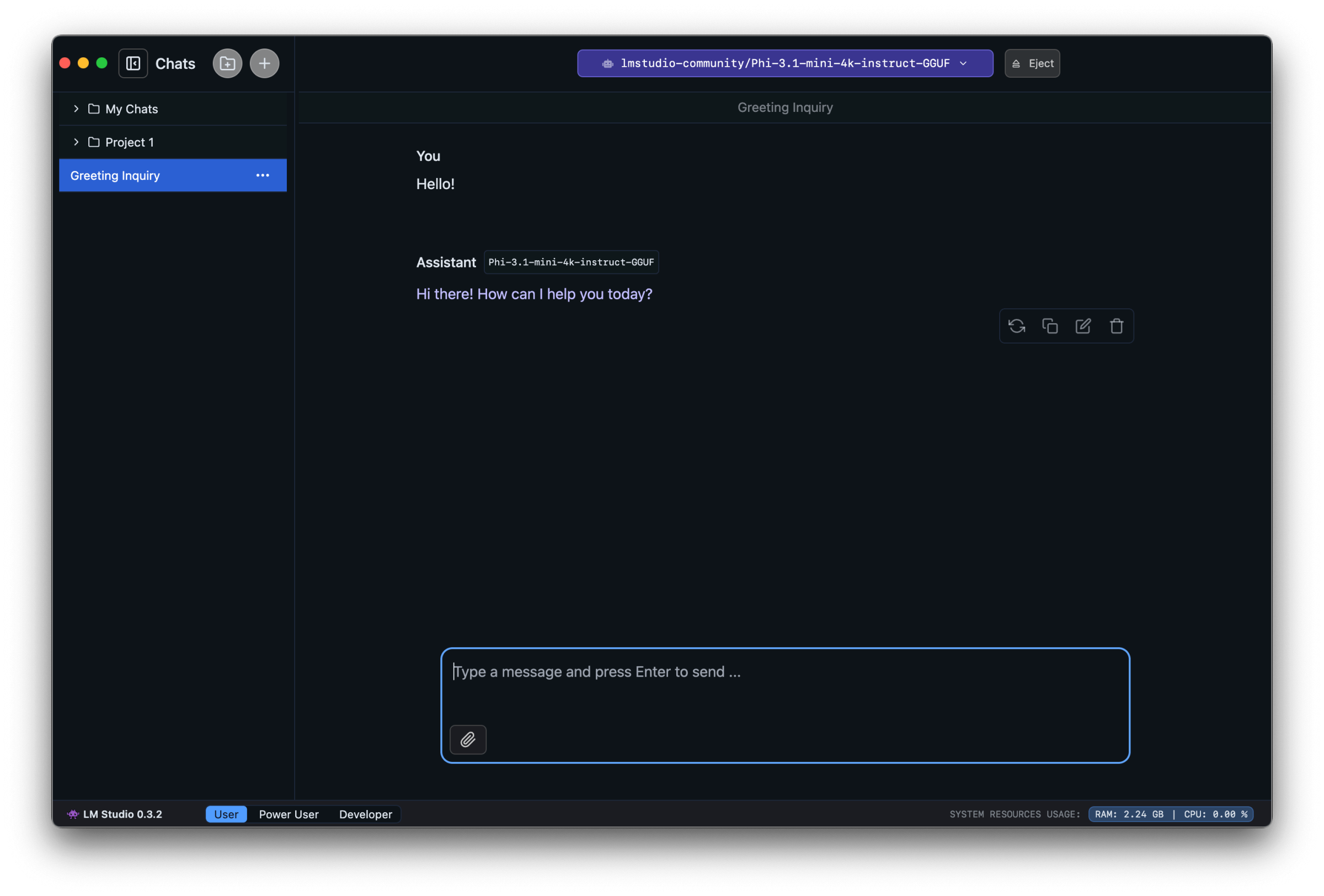

📌 Charger un modèle dans la mémoire

- Ouvrez l’onglet "Chat".

- Cliquez sur "Model Loader" (

⌘ + Lsur Mac,Ctrl + Lsur Windows/Linux). - Sélectionnez le modèle téléchargé.

- Configurez les paramètres si nécessaire, puis chargez le modèle.

💡 Que signifie "charger un modèle" ? Cela alloue la mémoire nécessaire à l’exécution du modèle en local.

📌 Commencer à discuter avec un modèle

- Une fois le modèle chargé, tapez un message dans l’interface.

- Observez l’IA répondre en temps réel ! 🚀

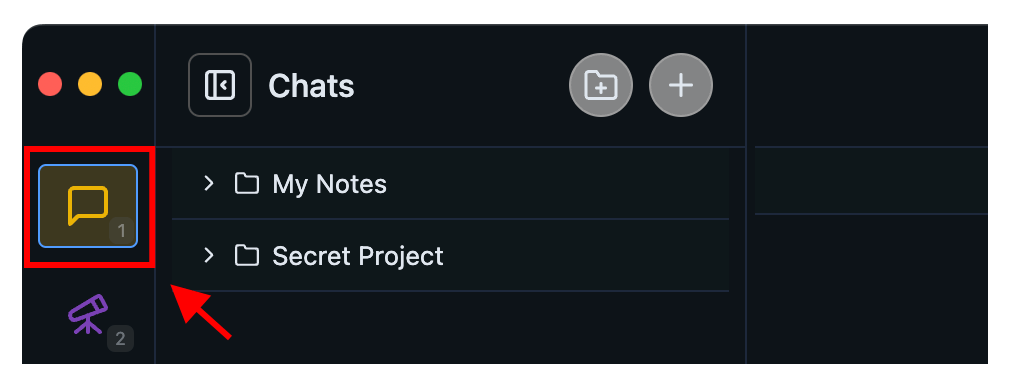

📂 Gérer ses conversations

L'application vous permet de gérer plusieurs discussions comme dans ChatGPT :

- Créer un nouveau chat :

⌘ + N(Mac) ouCtrl + N(Windows/Linux) - Organiser dans des dossiers :

⌘ + Shift + N(Mac) ouCtrl + Shift + N(Windows/Linux) - Dupliquer un chat : Cliquez sur

•••puis "Duplicate" - Exporter les conversations (elles sont stockées en JSON)

📌 Emplacement des fichiers de chat :

- Mac/Linux :

~/.lmstudio/conversations/ - Windows :

%USERPROFILE%\.lmstudio\conversations

📖 Chatter avec des documents (RAG)

Vous pouvez ajouter des fichiers (.pdf, .docx, .txt) à vos conversations pour interagir avec leur contenu.

💡 Comment ça marche ?

- Si le document est court, le modèle l’ingère entièrement.

- Si le document est long, l'application utilise le Retrieval-Augmented Generation (RAG), qui extrait les parties pertinentes pour les fournir à l’IA.

📌 Conseil pour optimiser RAG : Formulez des requêtes détaillées et utilisez des mots-clés pertinents pour améliorer la précision des réponses.

🌐 Utiliser en mode serveur

Ce projet propose une API compatible OpenAI pour interagir avec vos modèles depuis des applications ou scripts :

- OpenAI Compatibility API

- LM Studio REST API (beta)

Vous pouvez ainsi appeler votre IA locale via des requêtes HTTP, comme avec une API GPT.

🔌 Mode hors-ligne : Fonctionner sans Internet !

L'application ne nécessite aucune connexion Internet pour : ✅ Exécuter des LLMs locaux ✅ Chatter avec des documents ✅ Servir des requêtes via l'API locale

Seules les opérations suivantes requièrent Internet : ❌ Télécharger de nouveaux modèles ❌ Rechercher des modèles sur Hugging Face ❌ Vérifier les mises à jour de l’application

🆚 Pourquoi choisir LM Studio plutôt qu’Ollama ?

Si vous avez déjà testé Ollama pour exécuter des modèles IA en local, vous avez sûrement remarqué que son installation et son utilisation nécessitent quelques manipulations en ligne de commande. Bien qu’efficace, cette approche peut être un frein pour ceux qui préfèrent une solution clé en main.

LM Studio, en revanche, brille par sa simplicité. Son installation se fait en quelques clics, sans besoin de lignes de commande ni de configuration complexe. De plus, son interface graphique intuitive permet de télécharger, configurer et exécuter des modèles sans effort. Que vous soyez un débutant curieux ou un utilisateur avancé, cette application vous offre une expérience fluide et accessible, là où Ollama peut sembler plus technique et austère. 🚀

Avec cette application, pas besoin de se soucier des dépendances compliquées ou d’apprendre des commandes spécifiques : tout est pensé pour une prise en main rapide et efficace. Alors, pourquoi se compliquer la vie ? 😎

Félicitations ! 🎉 Vous avez installé et configuré LMStudio avec succès. Vous pouvez maintenant explorer le monde fascinant des LLMs locaux, tester différents modèles et expérimenter en toute confidentialité. 🔒

🚀 Et maintenant ?

Dites-moi quel sujet vous aimeriez voir la semaine prochaine !

- 🤖 Créer un chatbot local ?

- 🔧 Optimiser les performances de l’IA sur votre PC ?

- 💾 Explorer les meilleurs modèles disponibles ?

Partagez vos suggestions en commentaire ! 📩🔥

À très bientôt pour une nouvelle aventure IA ! 🚀🤖